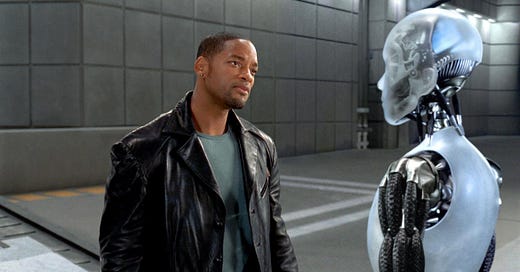

Possiamo fidarci delle macchine?

Una panoramica sul Machine Learning e i Modelli di Interpretabilità

Nell'era digitale, le macchine - ovviamente parliamo di Intelligenza Artificiale - hanno assunto un ruolo sempre più centrale nelle nostre vite. Dalle raccomandazioni di film su Netflix alle previsioni del tempo sullo smartphone, l'IA è ovunque. Ma una domanda sorge spontanea: possiamo fidarci delle macchine?

Per rispondere a questa domanda, dobbiamo prima capire cosa sia il machine learning, una delle principali tecnologie alla base dell'IA. Il machine learning è un metodo di analisi dei dati che automatizza la costruzione di modelli analitici. In parole povere, è un modo per insegnare (o addestrare) ai computer a imparare da dati ed esperienze passate e a fare previsioni o prendere decisioni senza essere esplicitamente programmati per farlo.

Tuttavia, e questo è il punto interessante, non tutti i modelli di machine learning sono creati allo stesso modo.

Alcuni modelli sono come scatole nere, che producono previsioni senza spiegare come hanno raggiunto quelle conclusioni. E questo non ci piace perché può essere un problema, specialmente quando questi modelli sono utilizzati in settori critici come la sanità o la finanza, dove le decisioni errate possono avere conseguenze gravi.

Per questo è importante introdurre il concetto relativo ai modelli di interpretabilità. Questi sono modelli di machine learning progettati per essere comprensibili e spiegabili.

Ci sono due tipi principali di modelli di interpretabilità:

Modelli intrinsecamente interpretabili: Questi modelli, come i modelli lineari o gli alberi decisionali, sono progettati per essere facilmente comprensibili. Le loro decisioni possono essere facilmente spiegate in termini di input e parametri del modello.

Tecniche di spiegazione post-hoc: Queste tecniche cercano di rendere interpretabili i modelli di machine learning più complessi, come le reti neurali. Generano spiegazioni per le decisioni di un modello dopo che il modello è stato addestrato.

L'utilizzo di modelli di interpretabilità può essere un fattore chiave per aumentare la fiducia nell'IA.

Se possiamo capire come un modello di IA prende le sue decisioni, possiamo avere più fiducia nel fatto che quelle decisioni siano accurate e giuste. Inoltre, i modelli interpretabili possono aiutare a identificare e correggere eventuali pregiudizi nei dati di addestramento, contribuendo a rendere l'IA più equa.

In conclusione, mentre l'IA e il machine learning offrono enormi potenzialità, è importante che comprendiamo come funzionano per poterci fidare delle decisioni che prendono. I modelli di interpretabilità sono uno strumento prezioso in questo senso, aiutandoci a capire e a fidarci dell'IA.